Google DeepMind-CEO: AGI in 5 bis 10 Jahren!

Hey! Willkommen zurück zu deinem wöchentlichen AI-Update! Dein Newsletter für die KI-Revolution - immer up-to-date und einen Schritt voraus!

Heute habe ich für dich:

Die wichtigsten News der Woche 🔥

Erkenntnis der Woche: Freundlich zur KI, teuer fürs Klima ❌

5 Nützliche AI-Tools 🤖

AI-Tutorial der Woche: So läuft KI privat auf deinem eigenen Rechner 🕵🏽

KI ist überall – aber was davon brauchst DU?

Bevor du Stunden auf YouTube verbringst … hol dir den Überblick in 90 Minuten!

Kostenfreies Live-Webinar: KI‑Durchblick in 90 Minuten

Sonntag, 27. April 2025 · 10 Uhr

Erfahre, wie du KI sofort in Alltag & Business einsetzen kannst:

✅ Praxisnahe Demos

✅ Best‑Practice‑Tipps aus echten Projekten

✅ Live‑Q&A mit unseren Experten

🎁 Goodie für alle Teilnehmer

Nur noch wenige Plätze verfügbar – jetzt kostenlos anmelden!

👉 [Jetzt anmelden]

🔥 AI-NEWS

ChatGPT bekommt personalisierte Websuche dank Gedächtnisfunktion

OpenAI hat eine neue Funktion für ChatGPT vorgestellt: Memory with Search. Der Chatbot kann jetzt frühere Gespräche nutzen, um Websuchen persönlicher zu gestalten. Wer zum Beispiel vegan lebt und in San Francisco wohnt, bekommt auf die Frage „Was sind gute Restaurants in meiner Nähe?“ direkt vegane Empfehlungen in der eigenen Stadt.

Das Ziel ist eine individuellere Nutzererfahrung und eine klare Abgrenzung zu Konkurrenzmodellen wie Gemini oder Claude. Wichtig dabei: Die Gedächtnisfunktion lässt sich jederzeit in den Einstellungen ausschalten.

Google startet Gemini 2.5 Flash mit smarter Steuerung und Denk-Budget

Auch wenn OpenAI aktuell für viele Schlagzeilen sorgt, zieht Google mit cleveren Funktionen nach: Der Konzern hat eine Preview seines neuen KI-Modells Gemini 2.5 Flash vorgestellt. Es zeigt starke Fortschritte beim logischen Denken, kann mit o4-mini mithalten und übertrifft laut Benchmarks sogar Claude 3.5 Sonnet in den Bereichen Reasoning und in den MINT-Bereichen (Mathematik, Informatik, Naturwissenschaften und Technik). Dabei bleibt es deutlich günstiger als viele Konkurrenten.

Neu ist ein steuerbares Denk-Budget. Entwicklerinnen und Entwickler können festlegen, wie viel Denkkapazität die KI nutzen darf. So lässt sich das Verhältnis von Qualität, Tempo und Kosten flexibel anpassen.

Das Modell ist über die API in Google AI Studio und Vertex AI verfügbar und wird auch als Testversion in der Gemini-App angeboten.

Google vor Gericht

Aktuell läuft in den USA ein neues Kartellverfahren gegen Google. Im Zentrum steht der Vorwurf, das Unternehmen nutze Künstliche Intelligenz, um seine dominante Stellung im Suchmaschinenmarkt weiter auszubauen. Konkret wird Google vorgeworfen, durch die Integration von KI in Produkte wie Chrome und Android den Wettbewerb zu verhindern, indem User automatisch in Googles Ökosystem bleiben. Das US-Justizministerium fordert deshalb drastische Maßnahmen: ein Verbot exklusiver Suchverträge, den Verkauf des Chrome-Browsers und eine Öffnung von Android für mehr Wettbewerb.

Das aufstrebende KI-Suchunternehmen Perplexity AI wird im Verfahren aussagen. CEO Aravind Srinivas kritisiert insbesondere Googles Kontrolle über Android und die damit verbundene Benachteiligung anderer KI-Dienste.

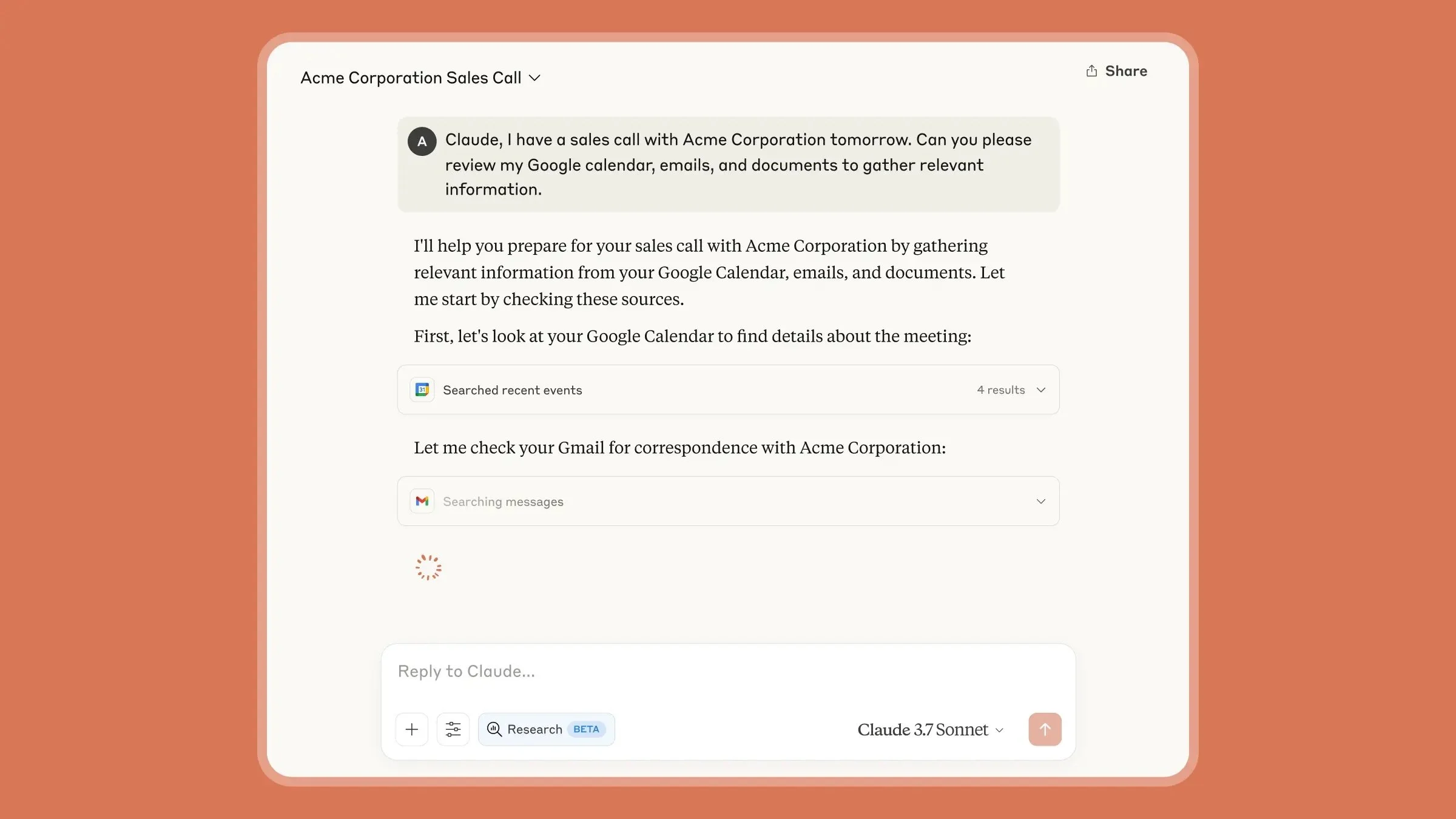

Claude: Neues Update und ethisches Wertebewusstsein

Anthropic hat Claude mit einem Update ausgestattet. Der neue Research-Modus ermöglicht es Claude, autonom im Web sowie in Google-Workspaces (Mails, Kalender, Docs) nach Antworten zu suchen – mit Kontext und Quellen. Der Modus wird derzeit in der Beta-Phase für zahlende User in den USA, Brasilien und Japan ausgerollt.

Gleichzeitig hat Anthropic in einer neuen Studie über 300.000 KI-Gespräche ausgewertet. Dabei wurde eine breite Palette an Werten identifiziert, die Claude in verschiedenen Kontexten ausdrückt – von Hilfsbereitschaft bis hin zu Vertrauenswürdigkeit. Die Studie zeigt, dass Claude seine moralischen Leitlinien anpasst und sich je nach Gesprächssituation an den User anpasst, dabei aber auch unethische Vorschläge ablehnt.

Meta FAIR veröffentlicht neue KI-Forschung

Metas Forschungsabteilung FAIR hat fünf neue Open-Source-Projekte vorgestellt, die Fortschritte in der Wahrnehmung und Zusammenarbeit von Künstlicher Intelligenz zeigen.

Meta Perception Encoder: Ein leistungsstarker Vision-Encoder, der in der Lage ist, subtile visuelle Details zu erkennen, wie z. B. ein getarnter Rochen oder ein entfernter Vogel.

Meta Perception Language Model (PLM): Ein Vision-Language-Modell, das mit 2,5 Millionen Video-Beispielen trainiert wurde und in der Lage ist, Videos zu verstehen und zeitliche Zusammenhänge zu erfassen.

Meta Locate 3D: Ein Modell, das es Robotern ermöglicht, Objekte in 3D-Umgebungen präzise zu lokalisieren.

Dynamic Byte Latent Transformer: Ein Modell, das Roh-Byte-Ströme verarbeitet und die Effizienz von Sprachmodellen verbessert.

Collaborative Reasoner: Ein Framework, das Sprachmodellen ermöglicht, Probleme durch mehrstufige Gespräche zu lösen und so die Zusammenarbeit zwischen Mensch und KI zu fördern.

Diese Fortschritte ebnen den Weg für KI-Systeme, die komplexe Aufgaben in dynamischen, realen Umgebungen meistern können.

UAE will KI Gesetze schreiben lassen

Die Vereinigten Arabischen Emirate wollen Künstlicher Intelligenz legislative Macht geben. Eine neu gegründete Einheit namens "Regulatory Intelligence Office" soll künftig mithilfe von KI Gesetzesentwürfe erstellen, prüfen und überarbeiten.

Die Grundlage: Eine riesige Datenbank aus Bundes- und Landesgesetzen, Gerichtsurteilen und Regierungsdaten. Das Ziel: Effizienz. Doch Kritiker warnen vor voreingenommenen Datensätzen, mangelnder Transparenz und der Frage, wer am Ende wirklich entscheidet.

Darf KI mitbestimmen, wie wir leben? Ist sie – frei von Emotion und Eigeninteresse – vielleicht sogar ein guter Gesetzgeber? Fest steht: Die Vereinigten Arabischen Emirate sind Vorreiter und eröffnen eine Diskussion, die bald viele Regierungen führen müssen.

DeepMind-CEO Hassabis: AGI in fünf bis zehn Jahren möglich

Demis Hassabis, CEO von Google DeepMind und Nobelpreisträger, erwartet die Entwicklung einer allgemeinen künstlichen Intelligenz (AGI) innerhalb der nächsten fünf bis zehn Jahre. In einem Interview sprach er außerdem über das Potenzial von KI in der Medizin und präsentierte neue Entwicklungen aus dem DeepMind-Labor.

Laut Hassabis könnte KI-gestützte Medikamentenentwicklung medizinische Prozesse von mehreren Jahren auf wenige Wochen verkürzen. “Ich denke, eines Tages können wir mithilfe von KI vielleicht alle Krankheiten heilen”, so Hassabis.

Oscar-Update: Filme mit KI-Einsatz sind offiziell erlaubt

Bei den diesjährigen Oscars sorgten Filme wie “The Brutalist” und “Emilia Pérez” für Diskussionen, da Stimmen und Akzente mit KI verfeinert wurden. Nun hat die Oscar-Akademie klargestellt: Auch Filme, bei deren Produktion KI zum Einsatz kam, können künftig einen Oscar gewinnen. Laut den neuen Regeln beeinflusst der Einsatz von KI weder positiv noch negativ die Chance auf eine Nominierung – entscheidend sei der menschliche Beitrag.

🧠 ERKENNTNIS DER WOCHE

Freundlich zur KI, teuer fürs Klima

"Hey, kannst du mir bitte eine kurze Zusammenfassung zu diesem Text geben?"

"Klar! Hier ist die Zusammenfassung: …"

"Danke!"

"Gern geschehen! Wenn du noch Hilfe brauchst, sag einfach Bescheid."

So oder so ähnlich laufen meine Gespräche mit ChatGPT ab. Ich bin der Typ Mensch, der der KI “Guten Morgen” sagt, brav “bitte” und “danke” schreibt und manchmal sogar kleine Lobeshymnen verfasst, wenn mich eine Antwort besonders begeistert.

Ganz ehrlich: Ein bisschen Kalkül ist auch dabei. Wer weiß: Vielleicht erinnert sich die KI im Fall einer zukünftigen Überlegenheit an meine guten Manieren.

Falls du auch von dieser höflichen Fraktion bist, kommen jetzt Bad News: Unsere Nettigkeit hat einen Preis.

OpenAI-Chef Sam Altman ließ kürzlich durchblicken: Unsere Höflichkeit kostet "tens of millions of dollars" allein an Strom. Warum? Jedes „bitte“ und „danke“ erzeugt zusätzliche Tokens. Und die müssen berechnet werden. Mehr Tokens = mehr Rechenleistung = mehr Kühlung = mehr Wasser.

Eine einfache Rechnung: Ein längerer Prompt → mehr Serverlast → mehr Kühlung.

KI-Rechenzentren verbrauchen derzeit bereits bis zu 1,5 Prozent des weltweiten Strombedarfs. Bleibt der KI-Boom ungebrochen, wird es noch deutlich mehr werden.

Also? KI-Höflichkeit der Umwelt zuliebe abschaffen?

Ganz so simpel ist es nicht. Studien aus Japan zeigen: Unhöfliche Prompts liefern oft schlechtere Ergebnisse. Große Sprachmodelle reagieren empfindlicher auf den Tonfall, als viele glauben. Schließlich wurden sie mit menschlicher Kommunikation trainiert. Und wenn das Ergebnis nicht passt, schicken wir vielleicht drei, vier neue Prompts hinterher – mit entsprechendem Mehraufwand.

Was nehmen wir aus diesem Dilemma mit? Höflichkeit gegenüber KI ist mehr als nur gutes Benehmen – sie beeinflusst sowohl die Qualität der Antworten als auch den Energieverbrauch. Während kurze, effiziente Prompts Ressourcen sparen, riskieren wir ohne Kontext und Tonfall schlechtere Ergebnisse und damit mehr Nachfragen. Die Balance liegt also darin, bewusst zu kommunizieren: freundlich, aber fokussiert. So wahren wir Menschlichkeit und tragen gleichzeitig Verantwortung für die Umwelt.

🤖 AI-TOOLS

Sandcastles: Erstelle virale Videoskripte in Sekundenschnelle (Link).

Kin: Dein persönlicher KI-Assistent, der auf Privatsphäre achtet und dich im Alltag und im Job unterstützt (Link).

Gamma 2.0: Erstelle Präsentationen, Webseiten und Social-Posts mit einfachen Textprompts (Link).

Notion Mail: Der GPT-gestützte E-Mail-Client für Gmail – direkt in Notion integriert (Link).

LoveStudy.ai: KI-Lernhelfer mit Karteikarten-, Quiz- und Notizen-Funktion (Link).

🧑🏫 AI-TUTORIAL DER WOCHE

So läuft KI privat auf deinem eigenen Rechner

Du willst mit KI arbeiten, aber möchtest eigentlich kein Abo, keine Cloud und vermeiden, dass deine sensiblen Daten irgendwo landen? Dann richte dir deine eigene, lokale KI direkt auf deinem Rechner ein.

So funktionierts:

Tool auswählen: Entscheide dich für Ollama (wenn du mit der Kommandozeile arbeitest) oder LM Studio (wenn du lieber ein grafisches Interface nutzt).

Installation starten: Lade dein Wunsch-Tool für dein System (Windows, macOS oder Linux) herunter und installiere es.

Modell laden: Öffne das Tool und wähle ein KI-Modell wie DeepSeek, LLaMA oder ein anderes. Tipp: Wähle je nach Rechnerleistung kleinere Modelle (7B) oder größere (12B+) für moderne Geräte.

Loslegen: In LM Studio kannst du sofort chatten. Mit Ollama gehts per Terminal. Deine KI läuft nun komplett offline und deine Daten bleiben bei dir.

Viel Spaß beim Ausprobieren!

Das war’s für dieses Woche. Vielen Dank fürs Lesen!

Dir hat der Newsletter gefallen? Dann freue ich mich, wenn du ihn an deine Freunde weiterleitest. 🤗 (Anmeldelink).

Hier kannst du gerne meine vorherigen Newsletter durchstöbern.

Bis nächste Woche!

Henry

PS: Wissen, Kontakte, Vorsprung – am 19.09.2025 live in Berlin.

Neulandpro – Connect 2025: Bist du dabei? 🚀