OpenAIs neue KI geht viral

Die stärkste AI-Community und -Lernplattform Deutschlands

Hey! Willkommen zurück zu deinem wöchentlichen AI-Update! Dein Newsletter für die KI-Revolution - immer up-to-date und einen Schritt voraus!

Heute habe ich für dich:

Die wichtigsten News der Woche 🔥

Erkenntnis der Woche: Doch nicht so intelligent? Warum Maschinen an simplen Aufgaben scheitern 👎

5 Nützliche AI-Tools 🤖

AI-Tutorial der Woche: Komplizierte YouTube-Videos easy verstehen 🎓

🔥 AI-NEWS

OpenAI integriert Bildgenerierung in GPT-4o und Sora

OpenAI hat eine neue Bildgenerierungsfunktion direkt in sein GPT-4o Modell und den Sora-Videogenerator integriert. Bisher waren Systeme für Text und Bild getrennt. Jetzt werden Bilder als Teil des Gesamtmodells verstanden. Das macht vor allem die Darstellung von Text in Bildern einfacher. Früher gab es oft Probleme mit unleserlichem Text: Beschriftungen oder andere Textinhalte sahen meist kryptisch aus. Jetzt können sogar ganze Menüs, Diagramme und Infografiken mit klarem, lesbarem Text erstellt werden.

Ein weiterer Vorteil: Nutzer können Bilder mit natürlicher Sprache bearbeiten, während das Modell dafür sorgt, dass alle Änderungen konsistent bleiben. Die 4o-Bildgenerierung ist ab sofort für Plus-, Pro-, Team- und Free-Nutzer verfügbar. Enterprise und Edu erhalten in Kürze Zugriff. Sie ist auch in Sora verfügbar. Für alle, die DALL-E vermissen, ist der Zugriff weiterhin über ein eigenes DALL-E GPT möglich.

Wer mehr erfahren möchte zu dem Update, kann sich hier mein neues YouTube Video dazu anschauen.

OpenAI bringt Sprach-KI mit personalisiertem Sprachstil

Wir bleiben bei OpenAI: Das Unternehmen hat seine neuen API-basierten Audio-Modelle für Text-to-Speech und Speech-to-Text vorgestellt. Entwickler können nun den Sprechstil der KI über einfache Prompts anpassen – etwa mit "Sprich wie ein Pirat" oder "Benutze eine Gute-Nacht-Geschichten-Stimme". Das neue GPT-4o-mini-tts Modell reagiert auf diese Eingaben und liefert den gewünschten, personalisierten Sprachstil.

Auch das GPT-4o-transcribe überzeugt: Das Modell erreicht Spitzenwerte in Genauigkeit und Zuverlässigkeit bei der Spracherkennung und übertrifft bestehende Modelle. Die Modelle sind über die OpenAI-API verfügbar und werden über das Agents Software Development Kit (SDK) für Entwickler integriert. Über die Plattform openai.fm können Nutzer das Text-to-Speech-Modell mit seinen verschiedenen Stimmen ausprobieren.

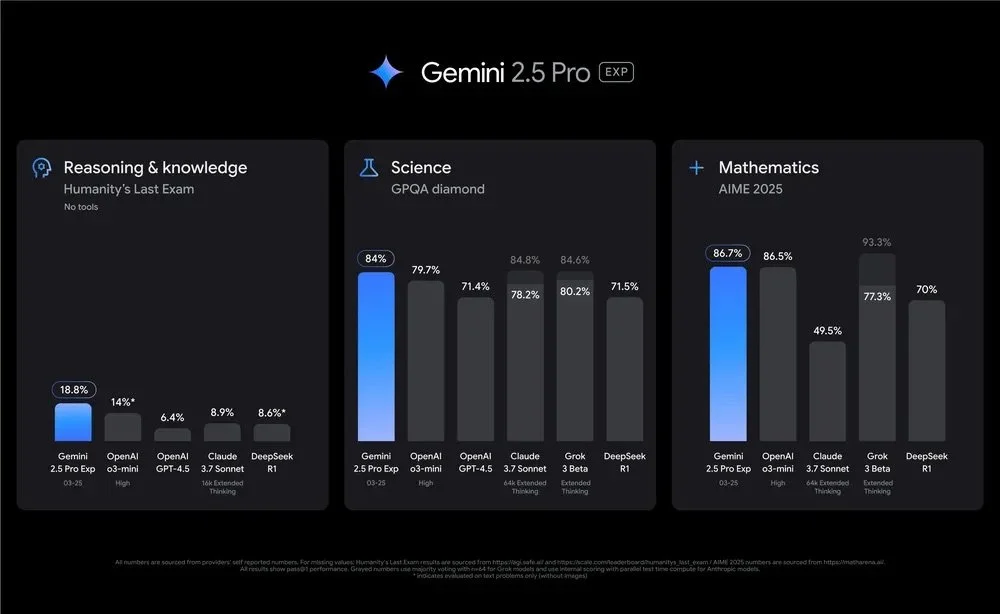

Google Gemini 2.5 Pro führt die KI-Rangliste an

Google hat sein neuestes Modell, Gemini 2.5 Pro, vorgestellt, das sich sofort in die Spitzenposition in wichtigen KI-Benchmarks, darunter Chatbot-Arena, katapultiert hat. Das multimodale Modell verarbeitet Text, Audio, Bilder, Video und Code und erzielt bemerkenswerte Ergebnisse in komplexen Tests wie GPQA und AIME. Mit einer 1-Million-Token-Kontextgrenze, die bald sogar noch auf 2 Millionen erhöht werden soll, setzt es neue Maßstäbe für die Verarbeitung großer Datenmengen. Verfügbar ist es bereits im Google AI Studio und der Gemini-App für Advanced-Abonnenten.

Zusätzlich hat Google Gemini nun auch eine Live-Videoanalyse über die Smartphone-Kamera integriert. Diese Funktion ermöglicht es, in Echtzeit Inhalte zu erkennen und bietet damit neue Möglichkeiten für die mobile KI-Interaktion.

Meta bringt AI-Assistent nach Europa

Hast du bei WhatsApp oder Instagram schon den blauen Meta-AI-Icon entdeckt? Meta bringt seinen KI-Chat-Assistenten jetzt nach Europa und du kannst ihn ab sofort auf Facebook, Instagram, WhatsApp und Messenger nutzen. Der Assistent ist in sechs europäischen Sprachen verfügbar und hilft dir mit schnellen Antworten oder Ideen. In Gruppenchats reicht es, „@MetaAI“ zu schreiben, um Unterstützung zu erhalten.

Apple tauscht KI-Führung aus – Siri soll aufgepäppelt werden

Apple nimmt massive Veränderungen in der KI-Führung vor, um die Entwicklung von Siri voranzutreiben. Mike Rockwell, der Schöpfer von Vision Pro, übernimmt nun die Leitung von Siri, um die verzögerten KI-Features zu beschleunigen und den Wettbewerbern näherzukommen.

Die größten Siri-Updates wie personalisierte Funktionen wurden wiederholt verschoben, ohne einen klaren Veröffentlichungstermin. Ein interner Bericht deckte zahlreiche Entwicklungsprobleme auf, was die Veränderung wenig überraschend macht.

Claude bekommt Echtzeit-Websuche

Anthropic hat eine neue Funktion für Claude eingeführt: Der KI-Assistent kann nun in Echtzeit im Web nach Informationen suchen und liefert Antworten mit Quellenangaben. Diese Erweiterung soll vor allem bei zeitkritischen Anfragen helfen und die Genauigkeit der Antworten verbessern. Die Websuche ist aktuell für alle Pay-User in den USA verfügbar, weitere Regionen folgen.

DeepSeek veröffentlicht V3-Upgrade

Das chinesische KI-Startup DeepSeek hat das stark überarbeitete LLM „V3-0324“ vorgestellt, das mit einer Mixture-of-Experts-Architektur arbeitet (eine Technik, bei der nur bestimmte Teile des Modells genutzt werden, je nachdem, welche Aufgabe gerade zu lösen ist, um so weniger Rechenleistung zu benötigen).Tester berichten, dass es problemlos auf Apple Mac Studio Computern läuft, was es zum ersten Modell dieser Art macht, das außerhalb von Rechenzentren genutzt werden kann.

Es bietet verbesserte Mathematik- und Codierungsfähigkeiten und ist nun unter der offenen MIT-Lizenz verfügbar, was eine breitere Nutzung ermöglicht. Diese Entwicklung könnte der Auftakt für noch größere Innovationen sein – Gerüchte über die kommende R2-Version nehmen bereits Fahrt auf.

KI diagnostiziert Gebärmutterkrebs mit nahezu perfekter Genauigkeit

Forschende haben ein KI-Modell namens ECgMLP vorgestellt, das Gebärmutterkrebs mit einer beeindruckenden Genauigkeit von 99,26 % anhand mikroskopischer Gewebeproben erkennt. Damit übertrifft es sowohl menschliche Experten als auch aktuelle automatisierte Verfahren deutlich. Das Modell nutzt spezialisierte Aufmerksamkeitsmechanismen, um Krebszellen zu identifizieren, die Ärzten bei herkömmlichen Analysen entgehen könnten.

Weitere Tests zeigten auch bei anderen Krebsarten wie Darm-, Brust- und Mundkrebs eine hohe Genauigkeit. Dieser Durchbruch könnte die medizinische Diagnostik revolutionieren und dazu beitragen, weltweit besseren Zugang zu Krebsfrüherkennung zu schaffen.

🧠 ERKENNTNIS DER WOCHE

Doch nicht so intelligent? Warum Maschinen an simplen Aufgaben scheitern

Bei aller AI-Liebe: Findest du es auch manchmal gruselig, wie schnell AI sich in den letzten Jahren entwickelt hat und was sie auf einmal alles kann? Vor ein paar Jahren war es noch nette Spielerei, heute kann KI ganze Filme generieren, Websites programmieren, Kunden beraten und sogar medizinische Diagnosen stellen. Da kann einem schon mal schwindelig werden. Irgendwann kommt da die Frage: Sind wir Menschen der Maschine überhaupt noch überlegen?

Spoiler: Aber sowas von.

Denn so beeindruckend KI in vielen Bereichen ist: Es gibt erstaunlich einfache Dinge, an denen sie kläglich scheitert. Aufgaben, die du easy morgens verschlafen beim ersten Kaffee hinkriegen könntest. Klingt absurd, ist aber Realität.

Beim kürzlich veröffentlichten ARC-AGI-2 Benchmark, einer Art Intelligenztest für Maschinen, wurden aktuelle KI-Modelle mit scheinbar simplen visuellen Aufgaben getestet. Ergebnis: Selbst die besten aktuellen Modelle wie OpenAIs o3-low oder Googles Gemini 2.0 Flash scheiterten spektakulär. Menschen lösen dieselben Aufgaben in wenigen Sekunden.

Wieso? Weil echte Intelligenz mehr bedeutet, als nur Wissen zu reproduzieren oder gelernte Muster zu erkennen.

KI hat drei große Schwachstellen:

Symbolische Interpretation: Symbole erkennen? Kein Thema. Aber verstehen, was sie bedeuten? Schwierig.

Kompositionelles Denken: Mehrere Regeln gleichzeitig anwenden? Überfordert jede KI.

Kontextuelles Verständnis: Eine Regel mal so, mal so anwenden, je nachdem, was gerade Sinn ergibt? Keine Chance.

Das zeigt: KI kann viel – aber echtes Denken ist flexibel, kreativ, effizient. Und genau das kann sie eben (noch) nicht. Der Schritt zur echten Allgemeinen Intelligenz (AGI) ist immer noch weit.

Genau diese Herausforderungen treiben die Forschung an. Benchmarks wie ARC-AGI-2 helfen, KI-Modelle gezielter zu verbessern und überall auf der Welt tüfteln Teams an neuen Lösungen.

🤖 AI-TOOLS

Reve Image 1.0: Bild-KI mit beeindruckendem Realismus und punktgenauer Prompt-Umsetzung (Link).

Diamond: Graphites agentenbasierter KI-Buddy, der dir hilft, deinen Code zu optimieren (Link).

KREA Video Training: Trainiere deine Video-KI und erhalte mehr Kontrolle über den Output (Link).

Epiphany: Verwandelt Sprachmemos direkt in Aktionen in deinen Lieblingstools (Link).

Promptimize: Browser-Erweiterung, die dir Experten-Prompts mit nur einem Klick liefert (Link)

🧑🏫 AI-TUTORIAL DER WOCHE

Komplizierte YouTube-Videos easy verstehen

Du siehst dir ein komplexes YouTube-Video, z. B. eine Vorlesung zu Quantenphysik, eine Erklärung zur Steuer oder einen Deep Dive ins Online-Marketing an und verstehst nur Bahnhof? Das Google AI Studio ist dein persönlicher KI-Nachhilfelehrer für jedes YouTube-Video, dem du gezielt Fragen stellen kannst.

So funktionierts:

Google AI Studio öffnen: Melde dich mit deinem Google-Account an.

Modell auswählen: Wähle im Dropdown-Menü “Gemini 2.0 Flash”.

YouTube-Link einfügen & Frage stellen: Kopiere den Link deines Lernvideos und gib ihn zusammen mit einer Frage ins Prompt-Feld ein.

Du hast jetzt verschiedene Möglichkeiten:

Stelle Fragen zu bestimmten Zeitstempeln: Beispiel: “Erkläre mir das Experiment ab Minute 05:30.”

Thema überblicken: Fordere eine Zusammenfassung an: “Gib mir eine einfache Zusammenfassung des Videos.”

Erstelle ein Quiz: “Erstelle mir einen Test zum Thema aus diesem Video.”

Perfekt, um neues Fachwissen schnell zu verstehen, dich auf Prüfungen vorzubereiten oder effizient weiterzubilden.

Viel Spaß beim Ausprobieren!

Das war’s für dieses Woche. Vielen Dank fürs Lesen!

Dir hat der Newsletter gefallen? Dann freue ich mich, wenn du ihn an deine Freunde weiterleitest. 🤗 (Anmeldelink).

Hier kannst du gerne meine vorherigen Newsletter durchstöbern.

Bis nächste Woche!

Henry